Security as an AI Enabler: 最先端セキュリティで生成AIの可能性を最大限に活かす

無限の可能性を秘める生成AIは、私たちの生活とビジネスに革新をもたらしています。しかし、その利用には潜在的なリスクが伴います。特に、企業がエンタープライズ環境で活用する場合には個人用途とは異なり、規制順守・データの正確性と平等性・プライバシーとセキュリティの厳格な管理が不可欠です。昨今はこうした課題への対処が不足していることから、多くの企業が生成AIの内部活用を躊躇しています。

本記事では海外の最新トレンドとソリューションに焦点を当て、生成AIを活用する際に必要なリスク管理と対策ソリューションをご紹介します。

※:本記事は、2023年11~12月開催の「MET2023」の講演を基に制作したものです。

【講演者】

生成AIの概況

昨今は、ChatGPTやOpenAIといった言葉をよく耳にするようになりました。ChatGPTは生成AIにおける1つのアプリケーションであ、それを実現させているのが大規模言語モデル「LLM」です。そして、各社が提供しているファウンデーションモデルを束ねているのが生成AIというカテゴリーであり、さらに上の階層にAIが存在します。

生成AIは、実にさまざまな企業で活用されています。たとえばメルセデス・ベンツ社ではGitHub Copilotを使ってソフトウェア開発を行ったところ、効率が30パーセントも加速をしたと言われています。

一方で、生成AIには使用リスクに対する懸念も少なくありません。Black Berry社が2023年の夏に出した統計によると、日本の組織は72%がChatGPTやその他のアプリケーションを既に禁止・あるいは今後の禁止を検討しているそうです。さらに、そのうちの58%は短期ではなく、中長期的な話となっています。皆さまが特に気にされている観点は、大きく分けると「品質」「セキュリティ」「信頼性」の3つです。

今回はこのうちセキュリティと信頼性に焦点を当て、各リスクの対策方法や、それを支援するソリューションをご紹介します。

昨今では生成AIのユーザビリティが向上し、人々にとってより身近な存在になりました。AI自体は昔から利用されてきましたが、従来のものはユーザーやスコープなどが限定的でした。一方、生成AIはその使いやすさから利用範囲が社外にも広がる可能性が高く、本当に多くの可能性を秘めています。

AIの民主化が一気に進めば、より多くのユーザーが色々なところで使うようになります。すると、それに伴ってリスクが広がり、コントロールする必要が出てきます。それこそが、最近になってAIのセキュリティが注目を浴びるようになった理由だと私は考えています。

AIが晒される脅威と対策

ここからは、AIに対するリスクと攻撃手法についてお話します。私は過去にサイバーセキュリティを手がけていたとき、「MITRE(マイター)」という組織が考案したATT&CK(アタック)というフレームワークを活用していました。そのMITREがAIのスレットランドスケープとして提供しているのが、誰でも利用可能な「ATLAS™」です。このサービスでは、AIに対する攻撃方法を攻撃者目線で詳しくマッピングしたものが示されています。

これに対し、「どのように守ればよいか」という観点でGartner社が提示したのが「AI TRiSM」という考え方です。これは2023年に同社が発表した「2024年の戦略テクノロジのトップ・トレンド」の1つ目の要素としても取り上げられています。

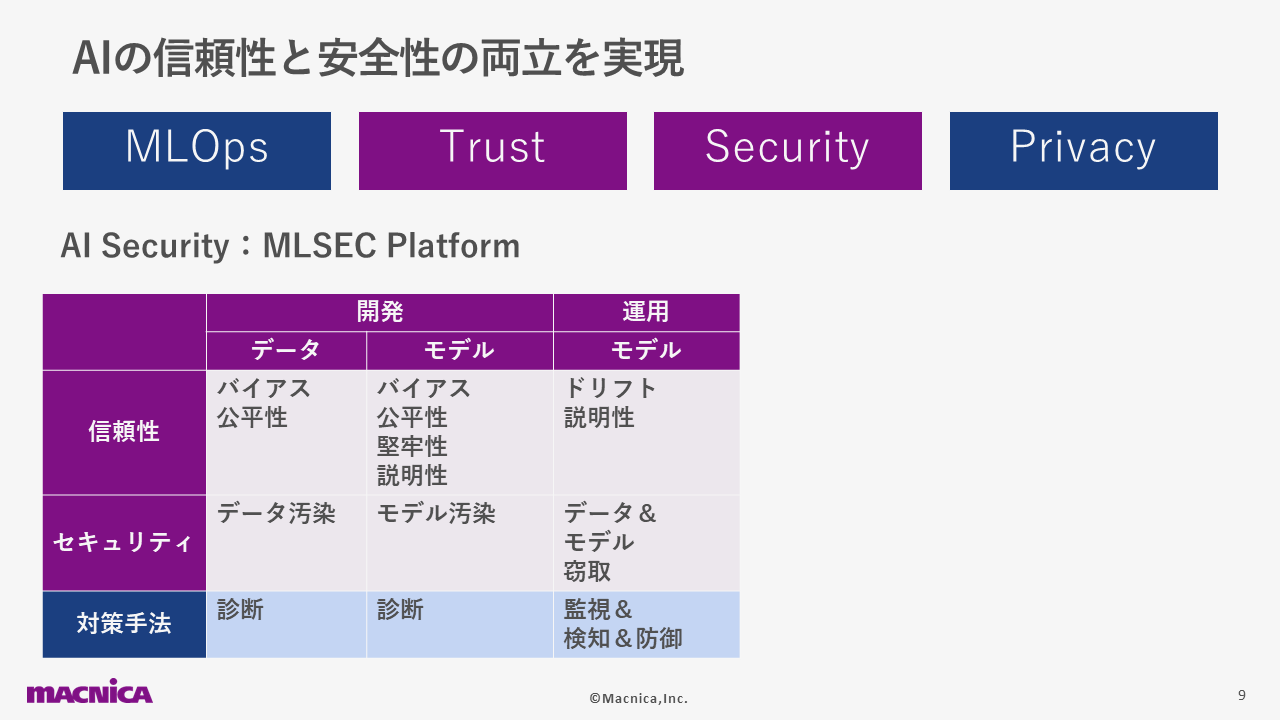

アメリカやイスラエルといったサイバーセキュリティが強い国では、パソコンやクラウドではなく、AIを守るスタートアップが次のステップとして出てきています。例としては、マシンラーニングのセキュリティを守るMLSEC Platformというジャンルがあります。MLOpsの会社様は開発時に品質だけではなく、信頼性も担保するために、さまざまな診断のテストのツールを出したり、運用時の監視のツールを出したりしています。

また、私たちはイスラエルのDeepKeepという会社に注目しています。同社が提供しているソリューションの特徴は、信頼性とセキュリティの両軸で監視・検知・防御をワンストップで行えることです。海外では、Privacy Enhancement Tecnologyというプライバシーのジャンルにも注目が集まっています。通常、データは分析時には暗号化が解かれていたり、脆弱な状態にあるのが基本です。データを守りながら分析する手法も色々なところで研究はされていますが、まだが学術レベルで実用的ではなかったり、Google社やIBM社のような膨大なリソースが必要だったりして、なかなか実現には至っていませんでした。

しかし、最近になって一般企業でもデータを安全なかたちで共有し、活用できる「TripleBlind」というソリューションが出てきました。これを利用すれば、データの漏洩を気にせずに他企業との共創や、AIモデル作成の依頼などが可能になります。また、ヨーロッパでは金融系の企業が不正送金の防止・詐欺検知・カードの情報共有などを行う際に精度を高めたり、安全にやり取りをするために使われています。

生成AIを安全に使うには?

さまざまな事例がある一方で、自社の目的がAIモデルの開発ではなく社内でのアプリケーション利用の場合、注意すべき脅威が何なのかが気になる方も多いと思います。そのヒントになるのが、OWASP(Open Web Application Security Project)という団体が出している、生成AIアプリケーションに潜む脅威のトップ10を示したものです。

トップ10の要素のうち「LLM01」はプロンプトに対する攻撃、「LLM06」は情報漏洩、「LLM09」はハルシネーションについて書かれており、それ以外はアプリケーション開発時に考慮すべき点を示しています。今回は、皆さまが特に気にされるであろう情報漏洩についてお話します。

生成AIの利用時には、プロンプトにユーザーが個人情報を入力してしまうリスクが多いにあります。もちろん、教育によって解決できる可能はありますが、全員がポリシーを守ってくれるとは限らないため、監視を徹底する必要があります。そこで私たちが注目しているのが、次世代の匿名化技術です。

匿名化技術は従来から存在しますが、特に日本語を扱う場合、精度の問題が少なくありませんでした。しかし、昨今では実用化できるレベルの技術が多く登場しており、それらが生成AIを安全に利用する際に、非常に役立つのではないかと考えています。なかでも特に注目しているのが、圧倒的な識別精度を誇るソリューション「PRIVATE AI」です。その精度は大手企業や匿名技術に特化したスタートアップが提供しているものと比べても非常に高く、さらにクラウドだけでなくオンプレにも対応しているため、日本の皆さまでも利用しやすいと思います。精度の高さの秘訣は、各言語ごとに作られたモデルにあります。また、モデル作成時に使われているデータも高品質、かつ量も多いことが特徴です。

たとえば海外の金融業者には、文字起こしした問い合わせの音声データをAIの分析にかけることで、顧客の傾向を把握したいという需要があります。しかし、会話の中にはさまざまな個人情報が含まれているため、うまくマスキングすることが困難です。そこで、PRIVATE AIが効力を発揮するというわけです。また、ChatGPTと連携して利用できる「PRIVATE GPT」も登場しており、これを介すことで機密情報の漏洩を防ぐ安全なチャットボットを使うこともできます。

皆さまはChatGPTなどを利用する際に、ブラウザを使うことが多いと思います。つまり、ブラウザ自体をセキュアにできれば、生成AIを安全に利用できるということです。そこで私たちは、Island社が提供している「Enterprise Browser」に着目しました。通常、一般ユーザー向けにデザインされたブラウザには、可視化や安全性の機能はありません。一方のEnterprise Browserは、エンタープライズに必要な要素を含めて再構築したものであり、金融業者ではVDIの補完や外部の委託業者の管理、小売・製造業ではゼロトラストの実現などに利用されています。

生成AIに関して言えば、ChatGPTにログインした際に「このようなリスクに注意してください」「社内のポリシーでは、○○が違反とされています」などの教育を、リアルタイムに施せます。ほかにも、機密情報に入力制限をかける・コピー&ペーストを制御する・アプリの使用に制限をかけることも可能なので、安全にChatGPTを利用できます。

生成AIのアプリケーションをWebサイトを通じて社外にも公開したり、サポートのチャットボットとして使ったりしたいという需要もあるかと思います。その場合、外部からの攻撃による情報漏洩への対策や、ハルシネーションによるレピュテーションリスクのコントロールが重要になります。プロンプトに対する攻撃は、プロンプトインジェクション・ジェイルブレイク・プロンプトリークなど、複数の種類があります。

プロンプトインジェクションは、プロンプトの中に悪質なものを入れることで、チャットボットを悪用する攻撃手法です。たとえばECサイトで商品の返品が行われる際、無条件で返品の受け入れをしたり、お詫びクーポンの割引率を故意に高くさせるといった事例があります。

ジェイルブレイクは、チャットボットが想定していない動作をさせるために危険度が高く、プロンプトリークは、チャットボットのシステムプロットを盗み出します。プロンプトインジェクションを成功させるための情報収集に使われています。ECサイトの返品条件を盗み見たり、商品の単価を調べたりといったことができてしまいます。

生成AIは、善悪の区別なく、無邪気に私たちを楽しませようとする子犬に近いと言われることがあります。与えられた課題・ミッション・プロンプトに対し、最大のアウトプットを出さんとしてはいるものの、その情報の真偽までは実は判断していないのが現実だと思います。それこそがハルシネーションに基づくレピュテーションリスクの発生や、脆弱性を突いた悪質なソフトウェアの出現につながっているのではないでしょうか。

その対策として今後活躍が期待されるのが、LLMのファイアーウォールです。これを使った防御には、「静的なルール」「プロンプロエンジニアリングのシステム化」「AIがAIに、本当に問題がないかなどの判断をさせる」という3つの手法があります。

いずれの手法でも重要になるのはThreat Inteligence、つまりどのような脅威が、どのような攻撃手法で訪れているのかを把握することです。それができなければ、防御体制をとることは不可能です。生成AIを社内外で安全に使うには、従来通りのセキュアなシステム構築や、提供する側・される側の教育が非常に重要です。

欧州や米国でも進むルール整備

最後に、AIの規制や法整備についてお話します。皆さまは、AI関連の規制は何個ぐらいあると思いますでしょうか。私が調査したところ、1600以上の規制が240以上の国に存在しました(※2023年後半時点)。これは、今後もさらに増えると予想されます。

規制に関しては、「理解」「成長」「整備」という、3つのステップが踏まれています。さまざまな国・団体・ダイバーシティも含めたチームがタスクフォースを結成し、AIそのものや影響を理解して予測する取り組みを進め、成長を促すための助成金や教育といった仕組みを作り、それらが正しく使われるように方向性が定められています。

そんななか、「EU AI Act」というAI規制法案が合意を得て、2023年12月から2024年初頭から2~3年かけて実施されることが決まりました。これには、GDPRに近いインパクトがあるとも言われています。この法案では、AI利用のリスクが「Minimal」「Limited」「High」「UNACCETABLE」の4段階に分けられています。

大まかには「UNACCETABLE」が使用禁止、「Limited」「High」がどこでどのように使っているかの通知義務あり、「Minimal」が基本的にベストプラクティスをするという内容です。ものによってはGDPR同様、基準に則らなかった場合に重い罰金が課されます。

なお、現在使われている生成AIの安全性については2023年6月時点にスタンフォードの研究団体が出したデータがあります。これによると、OpenAI社などの主要な企業48点満点中、おおむね半分くらいのスコアでした。「ファウンデーションモデルがアップグレードして性能は向上しているものの、それですべてをカバーはできていない」というのが、ポイントかと思います。

また、アメリカでも2023年の10月30日にバイデン大統領がExective Orderを出しました。図の項目では、「8つのGuiding PrinciplesとPrioritiesによって、AIの開発をちゃんと規制し、50の政府団体で150のリクワイアメントを作っていきましょう」という内容が示されています。また、「テクノロジーを安全に開発するためにサンドボックスのようなものを使いましょう」「使用禁止エリア」「一般企業の利用を促すための取り組み」など、先ほど登場した「理解」「成長」「整備」に当てはまる要素も含まれています。

アメリカでは州や業界ごとに次々とルールが増えていくため、情報を追い続けることが非常に重要です。それらをガバナンスする際、従来は診断&対策・報告&監視が注目されており、AIセキュリティソリューションはそこに対して非常に重要でした。一方で、今後は「そもそも社内のどこで使われているのか」「世の中のどういったポリシーがそれぞれのユースケースに適用されるのか」「誰が判断するのか」というワークフローを回す、AIのガバナンスにおけるプラットフォームが必要になります。

まとめ

今回は、AIのセキュリティに関わるいくつかのソリューションをご紹介しました。これらは、「社内業務効率化」「プロセス向上」「ビジネス革新」の3つの観点に分けられます。それぞれ公開範囲が社内だけなのか・社外も含めるのかであったり、どういったリスクに備えるべきなのかが異なるため、必要な商材も変わってきます。とはいえ、生成AIにおいては従来のアプリケーション同様、サイバーセキュリティやAPIセキュリティが重要であることは確かです。

マクニカは、セキュリティの調査およびお客様にご提供するソリューションやAIの取り扱い範囲を広げ、安全なAIの活用を今後も支援いたします。