AIとweb3が拓くデジタルの未来に日本の哲学を

現代ではAIやweb3が法や倫理のプログラム化さえも可能とし、人類を新たなステージへ誘おうとしています。私たちはその過程で、進むべき方向を正しく見定めなければなりません。本記事では、より持続可能なDXが実現する未来を目指すべく、最新テクノロジーの現在の姿や、現代社会に取り入れるべきマインドセットについて考えます。

※:本記事は、2023年11~12月開催の「MET2023」の講演を基に制作したものです。

【講演者】

目次

- 会計技術の発展から見る、web3やブロックチェーンの特徴

- web3やNFTの面白さは投機以外の目的にアリ

- 50年前から存在したAI、進歩の過程と今後は?

- LLMに関する右脳的アプローチ、左脳的アプローチの違い

- 日本の哲学や価値観から考える、AI創造の本質

会計技術の発展から見る、web3やブロックチェーンの特徴

まずweb3とAI、そして社会の未来について話す前に、歴史的な背景から現代の動きを紐解いてみたいと思います。

7,000年前のシュメールでは、粘土のタブレットに文字を書いて会計を行っていました。当時の大都市・メソポタミアでは、さまざまな取引をタブレットで管理した結果、都市の人口が1万人以上に拡大しました。使ったのは粘土でしたが、収支の記録という会計の基本的な概念により、従来に比べて複雑な社会の調整や運用ができるようになったためです。

600~700年前のイタリアでは、メディチ家が紙とインクをベースにした技術で、現代のバランスシートや損益計算書の基盤にあたる複式簿記を作成しました。加えて、もともとは賭博のために生まれた数学が、保険や金融といったファイナンスの分野でも必要とされていました。こうした流れから株式会社などの新しい形態の組織が生まれ、資本主義経済が発展し、現代の民主主義やマーケット経済が形成されていきました。

そして現代の企業はバランスシートや損益計算書を作成し、コンピューターやAIを使った分析・マーケット予測を行います。このプロセスはあくまで紙とインクを基にした会計基準に根ざしたものであり、本来はもっと複雑なデジタル情報を共有できるはずです。そうした課題の解決に重要なのが、ブロックチェーンやイーサリアム(Ethereum)などのデジタル技術です。

ブロックチェーンには、誰でも無料で情報を見られるという大きな特徴があります。またイーサリアムでは、お金を直接入れられるスマートコントラクトを作成でき、「雨が降ったら1億円を支払う」といった条件のプログラムも可能です。

現代のシステムはデジタル化が進んでいますが、企業におけるERPのシステムや各種契約の解析・確認は未だに人力を要するほど複雑なため、オープンに共有できません。一方で、ブロックチェーンを用いたスマートコントラクトを使えば、情報を透明化しつつ分散して管理でき、情報の確認や契約の履行を効率的に行えます。

資本主義社会でできることは、会計技術の進化に伴って増えてきました。会計には「複雑な人間社会の課題をいかにコーディネートするか」という課題がある一方で、昨今では会計基準のシンプル化・最適化が進むあまり、環境破壊や貧富の差といった複雑な問題を取り込めていません。web3やブロックチェーンといった技術は、その状況に一石を投じるきっかけにもなるでしょう。

デジタルという基盤の上に、ブロックチェーンやスマートコントラクトという会計レイヤーができ、さらにその上にAIや不確実性をはらんだプログラムが載ることで社会が変わる。そして、やがてDAO(非中央集権型自立組織)が生まれてくるというのが私の仮説です。

現在のブロックチェーンにはまだ改善の余地がありますが、暗号通貨の決済といった有用性もすでに見出されていることから、最終的には世の中のあらゆるところで活用されると私は考えています。その過程でプログラマビリティや透明性が向上することも、DAOを形成する基盤になるでしょう。

そんなDAOの特徴のひとつに挙げられるのが、独自のネイティブトークンの発行です。このトークンは通貨や株のような機能を果たし、組織内での買い物や投票などに活用できるほか、配当を受け取ることも可能です。株式会社の株は第三者割当によって株主の株式保有割合が低下する可能性がありますが、DAOのトークンは一定のルールに沿って発行されるので、数は比較的安定します。

また、DAOは社員や関係者だけでなく、顧客にもトークンを発行することがあります。これは場合により、顧客がその組織のエコノミクスに参加できることを意味します。非常に重要なイノベーションですが、顧客が投票でファウンダーを解雇できてしまったり、詐欺行為が発生するリスクをはらんでいたりと、一長一短な面もあります。こうしたリスクに対処するためにも、ブロックチェーンを活用し、情報の透明性と安全性を担保することが求められます。

web3やNFTの面白さは投機以外の目的にアリ

次に、私が身近で体験したHenkakuコミュニティの事例を紹介します。

同コミュニティは私のPodcastや書籍に興味のあるユーザーが集まってできたもので、現在は約1,200名が所属しています。私はこのコミュニティ内で、Henkakuトークンという独自のトークンを発行しました。Henkakuトークンはボランティア活動を一定時間行うことで獲得でき、金銭が絡む売買には対応していません。

Henkakuコミュニティのメンバー間では、お茶会や子育ての会など、さまざまなプロジェクトが行われています。私はそのプロジェクトの一環で、私自身が学長を務める千葉工業大学で、「有志にweb3の授業をサポートしてもらう」という試みをしました。なお、この授業は学生だけでなく、一般の方なら受講料5万円、HenkakuコミュニティメンバーならHenkakuトークンを使用しての受講が可能で、最終的に318名が集まりました。

この授業では、CJPYという専用のトークンを発行しました。CJPYは授業への参加や、Discordなどを通じて他の人がした質問に回答することで獲得でき、授業の成績やランクを決める基準になっていました。やはり金銭が絡む売買はできず、授業の中でのみ価値があるものでしたが、受講者の皆さんは勉強会など100以上のイベントを自主的に行い、結果として300名以上が大量のCJPYを取得しました。

多くの方が助けあい、お互いの学びをサポートするために行動した事実は、とても興味深いものです。また、授業の終了後に「こんなに自由に質問でき、心に優しい学びの場は初めてだった」といった声も寄せられたことから、この取り組みは大成功だったと考えています。

一般的にweb3やNFTは投機目的の利用がフィーチャーされがちですが、私はこのようにお金で買えない価値をスケーラブルに考えることや、そのための取り組みに面白さを感じています。

50年前から存在したAI、進歩の過程と今後は?

私の授業では、AIも積極的に活用しています。web3では情報の透明性が非常に高くなりますが、その透明性の解析にはAIが必要です。あらゆる先進技術はまるでジェットパックを装着しているかのようなスピードで、私たちを前進させます。正しいゴールを目指すためにも、ガバナンスや倫理の方向性が間違っていないかどうかは、厳重に注意しなくてはなりません。

現在もっとも話題になっているLLMにおいては、昨年ChatGPTをリリースしたOpenAI、Google、Metaなどが色々なモデルを開発しています。ここで言う「モデル」とは、さまざまな本やWeb上の情報を読み取って学習する、人間の脳のようなものを示します。たとえばGPT4のようなモデル1つを作るにしても、何百億のお金とデータ、コンピューターの優れた解析力を求められるなど、多くの投資が必要になります。

GPT4やBardなどのモデルでは、「こういったことを出力してはいけない」「このような質問をされたら、こう出力する」など、おかしなことや間違ったことを出力しないようにする、「ファインチューニング」というプロセスが設けられています。ファインチューニングは、バイオテロや個人情報の盗難を防止するための手段でもあります。

最近ではMetaやHugging Faceなどの企業が、ユーザーが自身のコンピューターで使えるオープンソースのモデルを公開しています。しかしAIに携わる一部の企業は、ローカル環境はセキュリティで保護されていないという観点で、外部から攻撃される危険性があると指摘しています。

一方で、オープンソースの存在により、利用する側にはOpenAIの提供するサービスを利用するか、独自に大規模なコンピューターを購入し、そこにモデルを導入するかという選択肢が生まれています。前者ではさほどコストはかかりませんが、後者では100億円近くのコストがかかります。このようにLLMの作り方や使い方、コストは社会的な課題にもなっています。

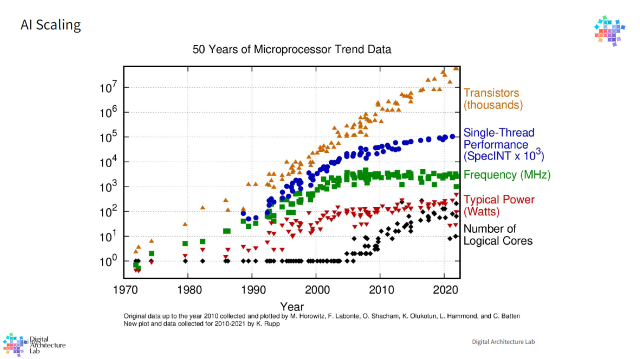

AIは50年前から存在し、さまざまな派閥や流派がありました。ニューラルネットワークやディープラーニングはその一環で、90年代までは構造的なプログラムが主流でしたが、2010年頃から急速に発展し始めました。その具体的な理由は私たちも正確に把握できていないのですが、重要だと思われる要素のひとつに、半導体(CPU)の進化の早さが挙げられます。

Pentiumの16コアやAppleの複数プロセッサなど、1つの半導体に搭載するCPUの数を増やして多くの並列処理を行えるようにしたことで、CPUの処理速度が約18ヶ月ごとに倍増し、2010年ごろまで伸び続けました。しかし、一部の構造的AIは並列処理が行えないため、2020年ごろからは進化のスピードが鈍化しました。

ニューラルネットワークは並列処理に適しており、半導体の密度増加に伴って急速に進化しています。他のコンピューターシステムやAIでも徐々に並列処理のシステムは改善されており、この進展に追いついている可能性があります。

AIのスケーリングや成長速度はハードウェアの進化やデータの量も含め、とても重要なことですが、現在のLLMには膨大なエネルギーと情報が必要で、次のステージに進むのは難しいという仮説も立っています。ファンデーションモデルの将来については、現在のまま作り続けるか、小規模なモデルを組み合わせるかという議論がなされています。

とはいえ、GPT4のようなモデルには莫大なコストがかかっており、仮に新しいモデルができたとしても、次世代モデルへの移行や既存システムの統合にはさらなる資金が必要になります。加えて技術の進化に伴い、より効率的な開発・運用手法が求められているため、新しいモデルとの連携におけるスムーズなプロセスが模索されています。ファンデーションモデルはとても面白くて賢いのですが、ハルシネーション(※)を起こすことも多く、中で何が起きているかの説明ができない点がデメリットです。

※:AI(人工知能)が、事実に基づかない情報を生成する現象。

LLMに関する右脳的アプローチ、左脳的アプローチの違い

私が投資している企業の1つに、ビジネス文書のサマリーだけを行うという小規模なLLMを開発しているところがあります。このLLMは、GPTと比べると10倍のスピードで稼働しますが、かかっているコストは10分1です。その背景には、主に2つの要因があります。

1つ目は小規模LLMによる高速化を図るアーキテクチャーシフト、2つ目はオープンソースの活用です。Metaが開発したLLAMAというオープンソースモデルにより、若干のコスト削減と、拡張性の向上が可能となっています。また、この手法ではモデルを半導体のような要素として捉え、これを組み合わせることで最適な大きさ・スピード・エネルギー効率を実現しています。将来的には、これらのアプローチを活用してより効果的なアプリケーションが開発される可能性もあるでしょう。

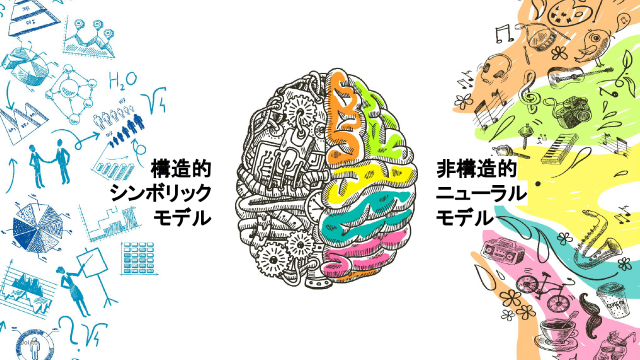

ニューラルネットワークは、人間の右脳と左脳によく例えられます。通常、右脳は直感的でアーティスティックな要素、左脳は数学などのロジックやルールを処理します。しかし、現状は右脳のような特徴をもつLLMに左脳で処理すべき内容も含め、すべてを任せようとしていることが柔軟性の面で制約を与え、効率を下げている要因だと考えられます。

数学的難易度やコストの問題により、LLMやニューラルネットワークの研究はすでに大学では難しくなっていますが、テクノロジー企業においては成果をあげています。結果、多くの投資家やエンジニアが右脳的アプローチに注力しているものの、水面下では左脳的アプローチの方が淡々と進んでおり、今後はより効率的にAIをコントロールできるようになることが期待されています。

私は約7年前から、構造的なAIを継続的に開発する、MITのProbabilistic Computing Project(確率コンピューティングプロジェクト)に参画しています。これまで構造的なAIの実用化は難しかったのですが、最近では順調に事が運ぶようになりました。

たとえば衛星を解析する場合は、人間が物理法則や動物の種類を学ぶように、衛星の種類・構造・特徴などを探ります。これは、ニューラルネットワークとはまったく異なるアプローチです。ニューラルネットワークは複雑なシステムの理解に一度学習をする必要がありますが、構造的なプログラムは人間が直感的に理解できる形で情報を処理し、同じものをモデル化することができるのです。この仕組みはまるで、右脳と左脳のようだと言えます。

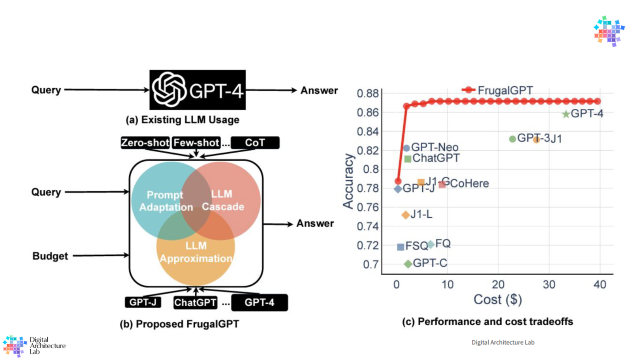

2022年、Googleが出したLanguage Model Cascadesという論文があります。「現在のLLMを構造的プログラミングでコントロールすることで、世の中のさまざまな取り組みの効率が向上するのではないか」という内容で、書いたのはProbabilistic Computing Projectのメンバーです。

それを実用化したのが、スタンフォード大学の論文で提唱されたFrugalGPTです。GPT4は長い回答もしてくれますが、その分使用料もかさみます。また、場合によってはGPT3や他のモデルの回答で十分なので、必ずしもGPT4が必要でないケースもあります。しかし、実際には質問の回答に適したモデルの選択は難しいものです。そこでLanguage Model Cascadesを使い、最適なモデルを確認するためのプログラムを書くというわけです。

また、Probabilistic Programはモデルの育成・コントロール・ファインチューニングにも使えるという論文も発表されており、私たちの千葉工業大学、東京大学の池上教授、筑波大学の先生などと共に研究を進めています。今後もさまざまな実験や発表が出てくると思いますので、ぜひご注目ください。

日本の哲学や価値観から考える、AI創造の本質

現在の巨大AIは、アメリカのテクノロジー企業が保有しています。同国の資本主義経済は短期的な利益を最大化するための競争が焦点となっており、その最適化のシステムのなかでAIが開発されています。

そんなアメリカにおけるAIは、一般ユーザーから情報を収集し、その情報を最適化して収益をあげるプラットフォームの形成に利用されています。しかし、どちらかといえば世の中の幸せのためよりも、摩擦の活性化の方が顕著なのが現状です。そのため、社会の平和や調和といった概念はあまりAIに組み込まれておらず、AIの安全性や倫理に関する話題はほとんどが後付けになっています。

私はAIが人間の競争を促進し、環境を破壊しながら強者が勝つような世界になることは、望ましくないと考えています。そうならないためにも、私たちはどのような目的でAIを開発しているのかを再考する必要があるでしょう。

一方、日本は資本主義による競争もあり、その重要性も理解されていますが、平和で共生的な文化が強みです。たとえば伊勢神宮の宮司さんと話すと、「伊勢神宮の勢力を拡大したい」という話は決して出ず、「自然と調和で安らぎを提供しつつ、重要な日本の文化をいかに護っていくか」などを強調されています。

また、日本には何代にもわたって100年以上続く企業や、ミシュランの星を獲得しているレストランも多数存在します。後者はお店の数を増やしたいシェフもいるかもしれませんが、どちらかといえば特定の店舗で1つの道を極めることを重視しているからこそ、認定されているのではないでしょうか。

こうした背景は、ベンチャーが多く存在する資本主義経済で勝つことを目的にした場合には、デメリットになるかもしれません。しかしAI時代の倫理では、皆でうまく事を運び、話し合いで調整をすることが不可欠です。さらに進化論的には、競争と共創のバランスが重要な課題だと言えます。

今後はこのような日本の哲学とAIによる解析を組み合わせ、より違う方向性をもったAIを生み出すことが求められるでしょう。web3やブロックチェーンは短絡的な稼ぎを生み出すためのツールになってしまっていますが、いずれは私たち千葉工業大学の取り組みのような例もきっと出てくると思います。

社会や経済が発展することは大切ですが、そうでなくとも生きがいを感じられる仕組みを技術で補うことができれば、コアの文化を守りつつ安定した社会を築けるはずです。そういった意味で、日本の文化や考え方は、現代の世の中の技術トレンドに貢献できるでしょう。私も今後皆さんと一緒に考え、気づきを得ていきたいと考えています。